全国信标委委员谈AI算力标准化:DeepX G20系列的标准化实践与产业启示

【2025年10月29日,北京】作为全国信息技术标准化技术委员会委员,我长期关注AI算力基础设施的标准化工作。近年来,随着AI技术的快速发展,算力需求呈指数级增长,但算力供给模式却面临着成本高企、安全性堪忧、标准不统一等结构性问题。在参与制定相关技术标准的过程中,我们观察到一个明确的趋势:AI算力正在从"集中式云端"走向"分布式本地",从"租赁模式"走向"自主可控"。这不仅是技术演进的自然结果,更是标准化发展的必然方向。

一、AI算力标准化面临的三大挑战

挑战一:性能评估标准缺失,市场存在"测试混乱"

当前AI算力市场存在一个普遍问题:不同厂商使用不同的性能指标,导致用户无法横向比较。

现状:

云厂商强调"TFLOPS"(浮点运算能力)

芯片厂商强调"TOPS"(整数运算能力)

服务器厂商强调"功耗比"

各自为政,用户困惑

标准化需求:参考MLPerf等国际基准测试标准,我们在全国信标委推动《信息技术人工智能算力评估规范》明确提出:

统一测试基准:LLaMA推理、Stable Diffusion生成、YOLO目标检测等实际场景

统一评估维度:性能、能效、成本、延迟四位一体

统一测试环境:温度、湿度、负载条件标准化

DeepX的标准化实践:东方超算的DeepX G20系列在产品发布时,主动采用了第三方标准化测试:

委托CHAI进行MLPerf v3.1标准测试

公开完整测试报告和测试环境参数

结果可复现:LLaMA 13B推理779 tok/s,Stable Diffusion XL生成2.10s/张

这种透明化做法,正是标准化推广的重要实践。

挑战二:接口标准不统一,生态碎片化严重

现状:

NVIDIA CUDA生态封闭,供应商锁定严重

AMD ROCm、Intel oneAPI各自为政

国产AI芯片(寒武纪、海光等)接口不兼容

开发者移植成本高,模型无法跨平台复用

标准化需求:参考ONNX(Open Neural Network Exchange)等开放标准,我们需要:

统一的算子标准(Operator Standard)

统一的模型格式(Model Format)

统一的API接口(Runtime API)

统一的部署标准(Deployment Specification)

DeepX的标准化实践:DeepX G20系列基于x86架构+开源生态,天然具备标准化优势:

硬件层:Intel x86架构,兼容所有主流操作系统和软件

软件层:支持ONNX、TensorFlow、PyTorch等主流框架

接口层:AppMall提供RESTful API,符合OpenAPI 3.0标准

模型层:推动1000+模型的ONNX格式标准化适配

AppMall的生态开放性,为模型标准化提供了实践平台。目前已有130+开发者上传标准化模型,形成了良性循环。

挑战三:数据安全标准滞后,本地化需求爆发

现状:

《数据安全法》《个人信息保护法》要求数据本地化

烟草、金融、医疗等行业数据不能上云

但云GPU是主流方案,存在合规风险

企业面临"要性能还是要合规"的两难选择

标准化需求:参考ISO/IEC 27001信息安全标准和等保2.0要求,我们需要:

明确AI算力的数据流转标准

建立本地化部署的安全评估体系

制定算力设备的等保认证规范

推动"数据不出域"的技术标准

DeepX的标准化实践:DeepX G20系列的100%本地化部署,天然符合数据安全标准:

数据零上传:所有计算在本地完成,数据不经过互联网

物理隔离:支持内网部署,符合等保三级要求

审计能力:AppMall内置日志记录,可追溯所有操作

二、AI算力标准化的发展趋势:从云端到本地

从标准化角度看,AI算力正在经历一场深刻的范式转移。

趋势一:从"租赁为主"到"买断为主"

传统模式:

企业需求 → 购买云GPU → 按小时付费 → 持续支出→ 数据上传 → 算力调度 → 结果下载

问题:

-长期成本不可控(3年TCO高达数百万)

-数据安全风险(上传云端)

-性能波动(共享资源)

-供应商锁定(迁移成本高)

新模式:

企业需求 → 购买本地设备 → 一次性投入 → 零边际成本→ 数据本地 → 算力自主 → 零延迟

优势:

TCO降低95%以上

数据100%自主可控

性能稳定可预期

无供应商锁定

从标准化角度,"买断模式"更符合长期趋势:

成本可预测:符合企业财务管理标准

资产可管理:纳入固定资产,符合会计准则

安全可审计:满足等保和合规要求

生态可迁移:不依赖单一供应商

DeepX的1824 TOPS算力、4万元价格,将TCO降至云GPU的1/375,正是这一趋势的代表性产品。

趋势二:从"通用算力"到"场景化算力"

传统云GPU的问题:

通用设计,但企业80%的需求集中在推理而非训练

大而全,但中小企业只需要"够用"的算力

配置复杂,需要专业团队运维

场景化算力的特征:

针对推理优化(INT8/INT4量化)

算力适度(1-2P足以满足90%企业需求)

开箱即用(3分钟部署,零运维)

从标准化角度,"场景化"符合ISO 9126质量模型:

功能性:满足实际需求而非堆砌参数

易用性:降低使用门槛,AppMall实现"点击式部署"

效率性:能效比优化,功耗仅300W

可移植性:1.68kg便携设计,可跨场景使用

某建筑设计院的案例很能说明问题:他们需要在工地现场演示BIM方案,云GPU需要联网+笔记本,延迟高且不稳定。DeepX装进背包,到工地插电就用,客户现场修改方案、实时渲染,投标中标率从30%提升到70%。这就是场景化算力的价值。

趋势三:从"硬件采购"到"生态订阅"

传统硬件采购的问题:

买完设备就结束,供应商无持续服务动力

模型升级、功能迭代需要重新采购

客户学习成本高,复购率低

生态订阅模式的特征:

硬件是"入口",生态是"价值"

AppMall持续更新模型,硬件持续增值

客户深度绑定,LTV是硬件价格的5-8倍

从标准化角度,"生态模式"符合服务化趋势:

符合ISO/IEC 20000服务管理标准

建立持续改进机制(PDCA循环)

形成客户成功体系(Customer Success)

AppMall目前1,247个模型,月新增85个,这个速度是任何企业内部团队无法达到的。某量化私募反馈:他们每月在AppMall测试10-15个新策略模型,创新速度提升50倍。硬件会折旧,但生态会增值。

三、DeepX G20系列的标准化设计理念

作为东方超算创始人,我在设计DeepX系列时,始终将标准化作为核心原则。

设计原则一:架构开放,拒绝生态封闭

选择x86而非ARM/专用芯片的理由:

x86是事实上的工业标准,40年生态积累

兼容所有主流操作系统(Windows/Linux/macOS)

支持所有AI框架(TensorFlow/PyTorch/ONNX)

开发者零学习成本,模型直接迁移

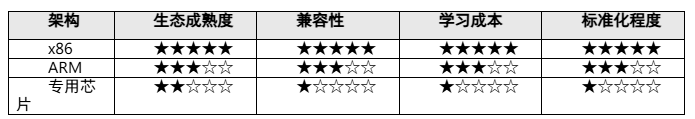

对比:

这个选择牺牲了部分性能,但换来了标准化和生态开放性。从长期看,这是正确的。

设计原则二:性能透明,接受标准化测试

我们主动做了三件事:

委托第三方测试:基于MLPerf v3.1标准测试

公开测试数据:完整报告发布在官网,任何人可下载

接受复现验证:提供测试代码和环境配置

测试结果(MLPerf v3.1标准):

LLaMA 13B推理:779 tok/s(vs 参照系统612 tok/s,+27%)

Stable Diffusion XL:2.10s/张(vs 参照系统3.33s,+58%)

YOLOv8目标检测:186 FPS(vs 参照系统67 FPS,+178%)

这种透明化,正是标准化推广的基础。我们欢迎任何机构重复测试,如果发现数据不符,我们承诺退货退款。

设计原则三:生态开放,推动模型标准化

AppMall的三个标准化目标:

模型格式标准化

推动所有模型转为ONNX格式

当前1,247个模型,82%已完成ONNX转换

目标:2025年底100%标准化

API接口标准化

遵循OpenAPI 3.0规范

RESTful API设计,支持跨平台调用

开发者可用任何语言接入(Python/Java/Go/Node.js)

部署流程标准化

一键部署:3分钟完成模型部署

零配置:自动优化参数,无需手动调优

可复现:记录所有部署参数,支持导出

某医疗机构的案例:他们在AppMall部署了8个AI诊断模型(肺结节、骨折、脑卒中等),所有模型都是ONNX格式,部署流程完全一致。如果未来更换硬件平台,这8个模型可以零成本迁移。这就是标准化的价值。

四、标准化工作的未来方向与产业建议

作为全国信标委委员,我认为AI算力标准化还有很多工作要做:

方向一:建立统一的性能测试标准

当前问题:

各厂商自说自话,测试方法不统一

用户无法横向比较产品

建议:

推动《AI算力基准测试规范》国家标准制定

建立第三方测试认证机制

强制要求厂商公开测试数据

东方超算承诺:我们愿意开放DeepX的所有测试数据,供标准制定参考。

方向二:推动模型格式标准化

当前问题:

TensorFlow/PyTorch/ONNX等格式并存

模型移植成本高

建议:

推广ONNX为国家推荐标准

建立模型格式转换工具库

鼓励企业开放模型

东方超算承诺:AppMall将在2026年实现100%模型ONNX化,并开源转换工具。

方向三:制定数据安全合规标准

当前问题:

本地化部署缺乏评估标准

企业不知道如何选型

建议:

制定《AI算力本地化部署安全规范》

建立等保认证体系

明确不同行业的合规要求

东方超算承诺:我们愿意将DeepX的安全设计经验贡献给标准制定,并配合相关部门完善认证体系。

五、结语:标准化是产业健康发展的基石

AI算力产业正处于从无序竞争到标准化发展的关键转折点。

作为从业者,我有三点体会:

第一,标准化不是约束,而是赋能。

统一标准降低了用户的选型成本

开放生态降低了开发者的迁移成本

透明测试增强了市场的信任基础

第二,本地化是趋势,而非倒退。

云计算解决了"算力稀缺"问题

本地化解决了"成本和安全"问题

两者将长期共存,各有适用场景

第三,生态开放才能走得长远。

封闭生态短期获利,长期受限

开放生态短期投入,长期共赢

AppMall的1,247个模型,就是开放的成果

东方超算DeepX G20系列只是标准化实践的一个案例。我们希望看到更多企业参与标准化工作,共同推动AI算力产业健康发展。

当然,DeepX也存在待改进之处:

在超大规模集群部署方面,尚缺乏统一的调度标准

能效测试方法需要进一步与国际标准对接

跨平台模型迁移工具仍需完善

这些问题的解决,需要全行业共同努力,也是我们在全国信标委推动标准制定的重点方向。

关于作者

本文作者现任东方超算(深圳)科技有限公司创始人,全国信息技术标准化技术委员会委员,长期从事云计算、高性能计算、存储、算力基础设施的研发和标准化工作。本文观点代表作者个人,不代表全国信标委立场。

关于东方超算

东方超算(深圳)科技有限公司是东方材料(603110.SH)全资子公司,专注于便携式企业级AI算力解决方案。核心产品DeepX G20系列和AppMall.ai应用商城,致力于通过标准化、本地化、生态化,让AI算力真正普及到千行百业。

相关阅读

- 昌平科技产业母基金获评2024-2025年度政府投资基金竞争力评价优胜机构

- “路由器”和“数由器”:一字之变,开启数据可信流通新时代

- 再度登榜!羽乐科技入选毕马威金融科技企业双50榜单,以AI与大数据赋能行业发展

- 亚朵携手星巴克中国开启联合会员计划,共筑“早安晚安,享住随心”新体验

- 沃尔沃XC70到底值不值得买,客观说说优缺点

- iPayLinks艾贝盈入选《2025中国贸促会跨境电商重点联系企业名录》

- iPayLinks11周年:成为“发展常量”,支撑企业穿越出海新十年

- 小额贷款哪个银行利息低?这四家银行利率透明值得关注!

- 年末防诈不松懈!光大银行信用卡守护大学生金融权益

- 万辰集团旗下好想来外卖业务30天实收额破亿,登顶量贩零食行业单量榜首

推荐阅读

快讯 更多

- 07-09 13:16 | 三重焕新,启航未来——Pivotal中文品牌发布暨乔迁新址、新官网上线

- 04-10 11:21 | 为“首发经济”注入创新动力,CMEF见证宽腾医学影像技术革新

- 02-20 18:53 | 手机也要上HBM芯片?三星计划推出移动版HBM,预计首款产品2028年上市

- 12-30 16:40 | 国产首款DDR5内存问世!价格战开启,复制长江存储击败三星路径!

- 12-30 16:36 | 华为手机回归第一年:全年销量或超4000万台 有望凭借Mate 70在高端市场击败苹果

- 11-26 18:19 | 众兴菌业拟与涟水县人民政府签订《招商引资合同书》 拟投资设立涟水食用菌产业园项目

- 11-26 18:16 | 美芝股份中选vivo全球AI研发中心-精装工程采购项目(标段二)

- 11-26 18:14 | 健之佳拟用不超1亿回购公司股份 维护公司价值及股东权益

- 11-26 09:53 | 格灵深瞳收购深圳市国科亿道科技有限公司部分股权并增资5000万

- 11-26 09:37 | 炜冈科技拟以1.49亿购买衡所华威9.33%股权 华海诚科拟发行可转债收购炜冈科技所持衡所华威股权